.webp)

Airflow : Présentation du concurrent direct de DBT

Découvrez ce qu’est Airflow et comment l’outil fonctionne par rapport à DBT !

.webp)

Découvrez notre formation Analytics Engineer et développez une des compétences les plus recherchées sur le marché.

En bref : Apache Airflow est l'outil de référence pour l'orchestration de pipelines de données complexes. Contrairement à dbt qui se concentre sur la transformation SQL, Airflow pilote l'intégralité du workflow (ingestion, calculs Python/Spark, notifications). En 2026, la maîtrise d'Airflow est devenue une compétence charnière pour les Analytics Engineers souhaitant automatiser des flux de données robustes et scalables.

Airflow : Présentation du concurrent direct de DBT

Si vous travaillez avec des volumes de données toujours plus complexes à automatiser, vous avez sans doute entendu parler d’Apache Airflow. Plus qu’un simple outil, Airflow est devenu, au fil des années, une véritable référence pour orchestrer des pipelines data de bout en bout et automatiser le travail des équipes data. Souvent mis en parallèle avec DBT, son « concurrent direct » pour certains, Airflow joue pourtant un rôle bien plus large . Là où DBT structure et teste vos transformations SQL, Airflow orchestre l’ensemble du flux de traitement, en s’assurant que chaque étape s’enchaîne sans accroc. Dans cet article, plongez dans l’univers d’Airflow.

Qu’est-ce qu’Apache Airflow ?

Par définition, Apache Airflow est un gestionnaire de workflows open source, créé par Airbnb en 2014 pour répondre au besoin croissant d’automatiser et de planifier des tâches de traitement de données de plus en plus complexes. Depuis, Airflow est devenu un standard de facto pour coordonner des pipelines de données variés, avec une architecture pensée pour gérer la scalabilité et la fiabilité.

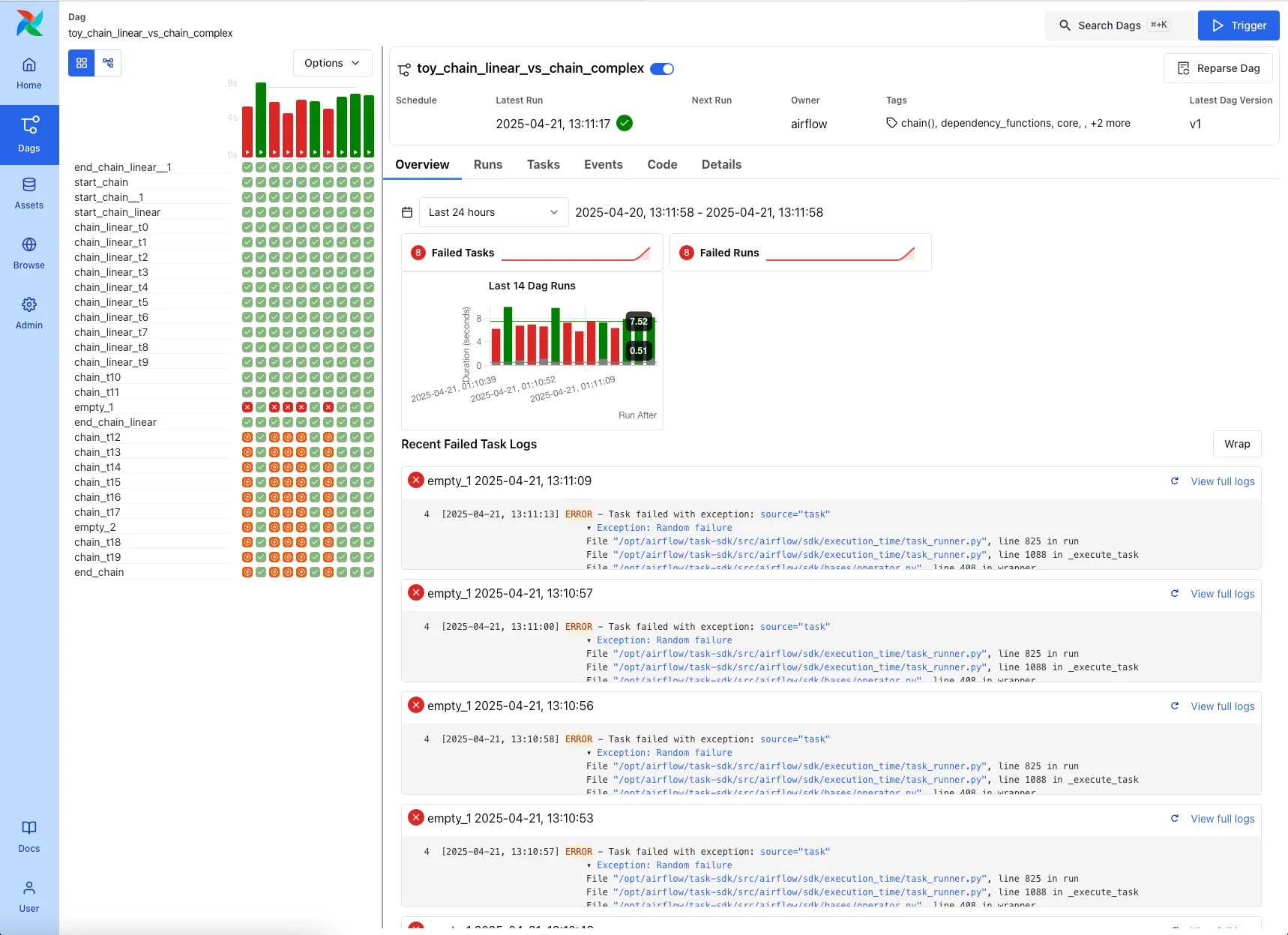

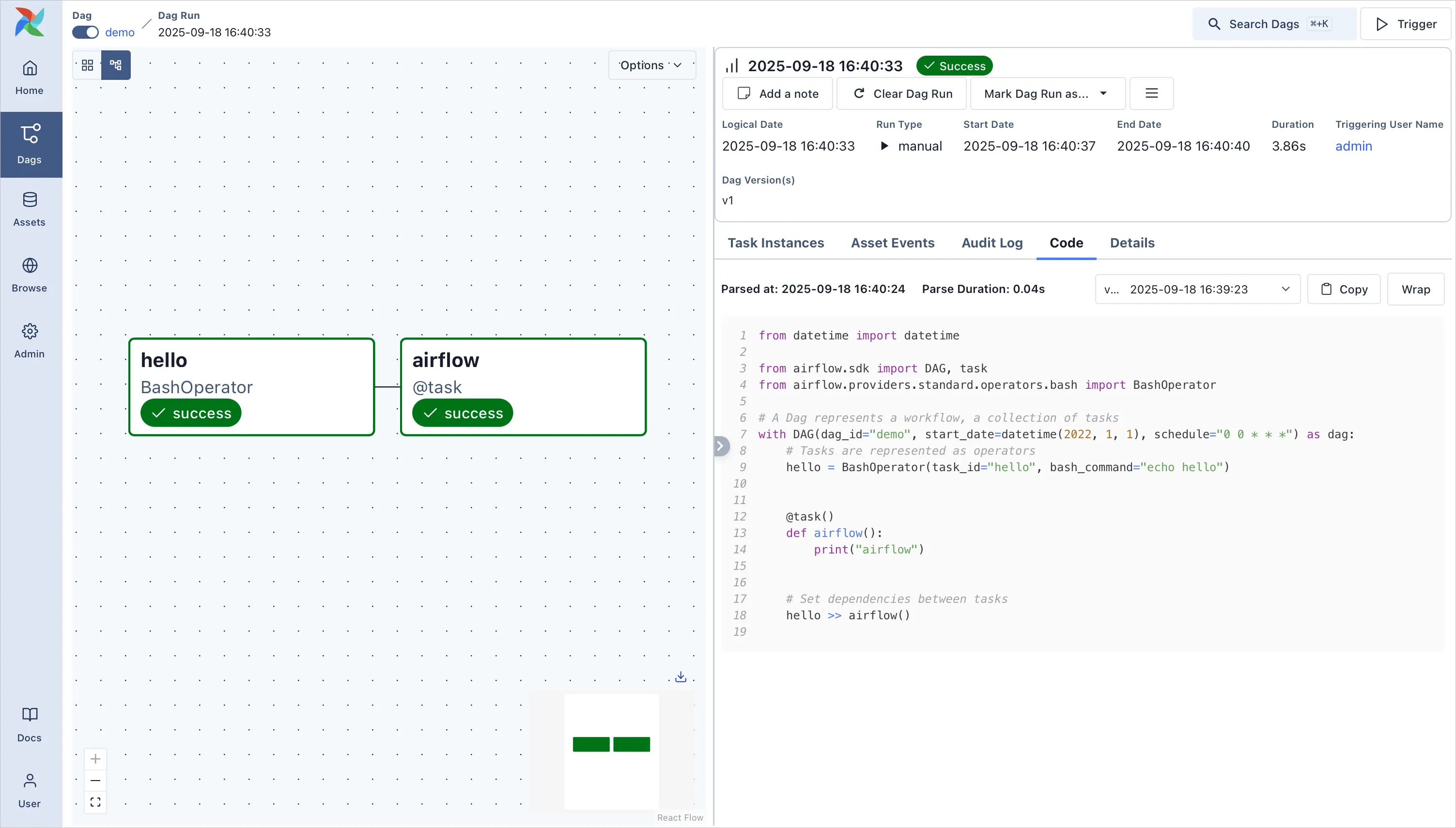

Concrètement, Airflow vous permet de modéliser vos pipelines sous forme de DAGs (Dirxxected Acyclic Graphs). Un DAG décrit l’enchaînement logique de tâches au sein d’un projet data. Chaque tâche peut être un script Python, une requête SQL, un job Spark, un appel d’API ou même l’exécution d’un workflow DBT. Airflow garantit que ces tâches s’exécutent dans le bon ordre, selon des dépendances explicites, avec une gestion précise des erreurs et des reprises.

Airflow : bien plus qu’un orchestrateur SQL

Ce qui fait la force d’Airflow, c’est qu’il est un orchestrateur généraliste, capable de gérer des workflows bien plus larges qu’un simple pipeline de transformation SQL. Voici quelques exemples de ce que vous pouvez automatiser avec Airflow :

- Extraire des informations depuis des API, des bases de données relationnelles ou des fichiers stockés sur le cloud.

- Nettoyer et préparer ces données grâce à des scripts Python ou des traitements Spark.

- Déclencher des pipelines de Machine Learning pour entraîner ou mettre à jour des modèles prédictifs.

- Orchestrer des appels à des services externes, envoyer des notifications Slack ou emails en cas d’incident.

- Exécuter des requêtes SQL ou lancer un workflow DBT pour structurer et transformer vos données dans un data warehouse.

Airflow vs DBT : quelles différences essentielles ?

DBT (Data Build Tool) est un outil open source qui se concentre sur la transformation des données en SQL directement dans votre entrepôt de données (Snowflake, BigQuery, Redshift, etc.). Il n’assure ni l’extraction ni le chargement : il part du principe que la donnée est déjà disponible et applique dessus des modèles SQL versionnés, testés et documentés.

DBT est devenu populaire car il démocratise des pratiques de développement logiciel pour la transformation SQL (tests unitaires, documentation automatique et gestion du lineage). Son adoption est particulièrement forte chez les Data Analysts et les Analytics Engineers, qui peuvent ainsi gérer la logique métier sans avoir besoin de coder en Python.

À l’inverse, Airflow est conçu pour orchestrer l’ensemble du pipeline, y compris l’ingestion, la transformation (qu’elle soit en SQL ou autre) et toutes les tâches annexes. C’est pourquoi, dans les architectures modernes, DBT et Airflow sont souvent complémentaires plutôt que concurrents. Airflow pilote tout le workflow et déclenche DBT pour exécuter les transformations SQL.

Pourquoi Airflow reste indispensable ?

Une orchestration multi-technologies

Airflow ne se limite pas au SQL : il pilote aussi bien des scripts Python, des jobs Spark, des workflows de Machine Learning, des flux Kafka ou encore des appels à des API REST. Cette polyvalence est essentielle pour orchestrer des pipelines hybrides et interconnectés, dans lesquels chaque technologie apporte une brique spécifique.

Une planification flexible et un monitoring centralisé

Airflow est reconnu pour la robustesse de son scheduler, qui vous permet de planifier des exécutions selon une logique cron, de déclencher des workflows sur des événements externes ou de conditionner certaines tâches à la réussite d’autres. Chaque exécution est surveillée grâce à une interface web intuitive et des logs détaillés, afin de garantir un contrôle permanent sur la durée d’exécution et le bon déroulement de la production.

Un écosystème riche et une extensibilité totale

Autre atout majeur : l’écosystème Airflow. La communauté met à disposition de nombreux providers pour interagir facilement avec AWS, Google Cloud, Azure, Slack, Salesforce et bien d’autres services. Airflow est par ailleurs entièrement extensible. Vous pouvez développer vos propres opérateurs Python pour automatiser des tâches sur mesure et répondre à des besoins spécifiques de votre métier.

Scalabilité et résilience pour des pipelines critiques

Airflow est aussi conçu pour la scalabilité et la haute disponibilité. Il peut exécuter des milliers de tâches en parallèle, réparties sur un cluster de workers distribués, sans perte de performance, même lorsque les workflows deviennent stratégiques pour l’entreprise. Cette robustesse garantit que vos pipelines data restent fiables, quels que soient le volume traité et la complexité des dépendances.

Déployer Airflow : sur site ou en version managée ?

Airflow peut être déployé on-premise, sur vos propres serveurs ou dans votre cloud privé, pour garder un contrôle total sur la configuration, la sécurité et la conformité. Cette option reste idéale si vous disposez d’une équipe capable de gérer l’infrastructure et la maintenance.

Pour éviter cette gestion technique, beaucoup d’entreprises optent pour une version managée, comme Cloud Composer (Google Cloud), MWAA (AWS) ou Astronomer Cloud. Ces solutions prennent en charge l’installation, le scaling automatique et les mises à jour, ce qui vous permet de vous concentrer uniquement sur vos workflows.

En vérité, le choix entre sur site et managé dépend surtout de vos ressources internes et de vos exigences de sécurité. Dans tous les cas, vous bénéficiez d’un orchestrateur fiable, prêt à automatiser vos pipelines de données.

Quand utiliser Airflow seul et quand l’associer à DBT ?

Airflow seul est suffisant si votre pipeline de données est très hétérogène et comprend de nombreuses étapes hors SQL (extraction depuis plusieurs sources, enrichissement via des scripts Python, calculs Spark, entraînement de modèles, archivage automatique, etc.). Airflow assure à lui seul la cohérence et la planification de toutes ces étapes !

DBT seul peut suffire si votre infrastructure est déjà bien structurée autour d’un data warehouse et que votre priorité est de transformer proprement vos données brutes par des modèles SQL testés et documentés. Vous pouvez alors exécuter DBT via un simple cron ou un scheduler cloud minimaliste.

La combinaison Airflow + DBT reste toutefois le scénario le plus courant. Airflow orchestre le pipeline complet et déclenche DBT pour gérer la transformation SQL de façon propre et traçable. Vous tirez ainsi parti des avantages des deux outils, sans compromis sur la qualité ou la robustesse.

Comment faire pour se former à Airflow et à DBT ?

Maîtriser l'orchestration, c'est passer du script manuel au pipeline automatisé et résilient. Si vous voulez apprendre à concevoir, monitorer et scaler vos workflows de données, notre Formation Apache Airflow : Tutoriel pour apprendre la Data Orchestration sur Airflow ! vous plonge au cœur de l'outil. Vous n'y apprendrez pas seulement à écrire des DAGs, mais à structurer vos pipelines pour la production, à gérer les dépendances complexes et à optimiser vos ressources de calcul comme un expert

Le rôle de l'Analytics Engineer est de bâtir le pont entre la donnée brute et l'insight business. Chez DataBird, nous formons les futurs architectes de la donnée. Notre cursus vous apprend à transformer vos flux de données avec d'excellentes pratiques de software engineering : versioning, tests automatisés avec d'outils comme d'dbt, et orchestration fluide via Airflow.

{{formation-analytics-engineer="/brouillon"}}

Les derniers articles sur ce sujet

.webp)

Lean Management et data : comment gagner en efficacité opérationnelle ?