.webp)

Data Workflow : Optimisez vos Flux de Données, Boostez votre Productivité

Simplifiez la gestion de vos données et boostez votre productivité avec un Data Workflow efficace. Découvrez comment automatiser et optimiser vos flux.

Découvrez notre formation Analytics Engineer et développez une des compétences les plus recherchées sur le marché.

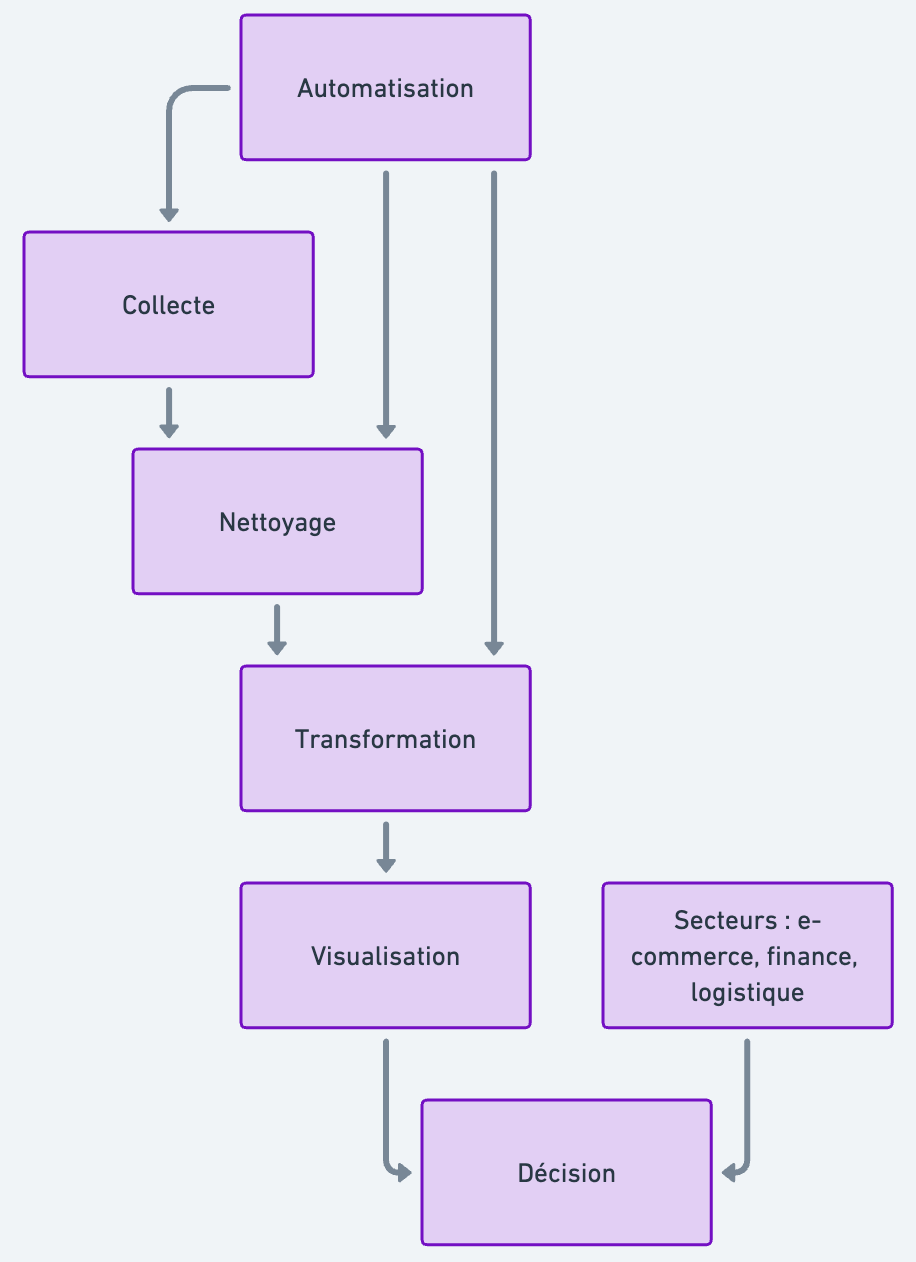

Le data workflow est un processus automatisé qui organise, transforme et met à disposition les données pour gagner en productivité et en fiabilité. Il élimine les tâches manuelles répétitives, réduit les erreurs et garantit une traçabilité complète des flux. En structurant les étapes de collecte, de nettoyage, de transformation et de restitution, l’entreprise crée un véritable service data durable et accessible.

Data Workflow : Optimisez vos flux de données pour une meilleure productivité

Dans un monde où les données sont devenues la matière première du digital, la capacité d’une entreprise à les exploiter rapidement et efficacement détermine sa productivité. Pourtant, beaucoup d’organisations perdent un temps considérable à manipuler des fichiers, à les copier, à les coller, à corriger des erreurs… souvent sans méthode.

C’est là qu’intervient le data workflow : un processus structuré qui automatise et orchestre la collecte, la transformation, le traitement et la mise à disposition des données. Il permet de créer un service data fluide, fiable et scalable.

Clara, analyste dans une PME de l’agroalimentaire, doit chaque semaine produire un rapport croisant les ventes régionales, la météo et les stocks. Aujourd’hui, tout est fait à la main. En construisant un data workflow, elle va transformer son activité.

Qu’est-ce qu’un Data Workflow ? Comprendre son rôle dans le monde de la donnée

Une définition concrète

Un data workflow, c’est un ensemble d’étapes automatisées qui permet de manipuler des flux de données de bout en bout : de la collecte à l’analyse. Il formalise les règles métiers, garantit la qualité des données et favorise l’automatisation des tâches répétitives.

Il est au cœur de nombreux systèmes d'information, notamment dans les secteurs du e-commerce, de la finance ou de la logistique, où les processus métiers sont complexes et fortement liés aux données.

De simples workflows à une orchestration complète

On distingue souvent plusieurs types de workflows :

- Manuels, gérés à la main via Excel ou emails

- Semi-automatisés, via des outils comme Make, Zapier, etc.

- Orchestrés, via des plateformes comme Apache Airflow ou Prefect

L’orchestration permet de superviser l’exécution, la mise à jour automatique des données, la gestion des erreurs et l’observabilité du travail de bout en bout.

Dans le cas de Clara, le passage d’un Excel bricolé à un workflow orchestré permet de fiabiliser chaque étape du processus.

Pourquoi votre entreprise a besoin d’un Data Workflow

Augmenter la productivité en automatisant les tâches

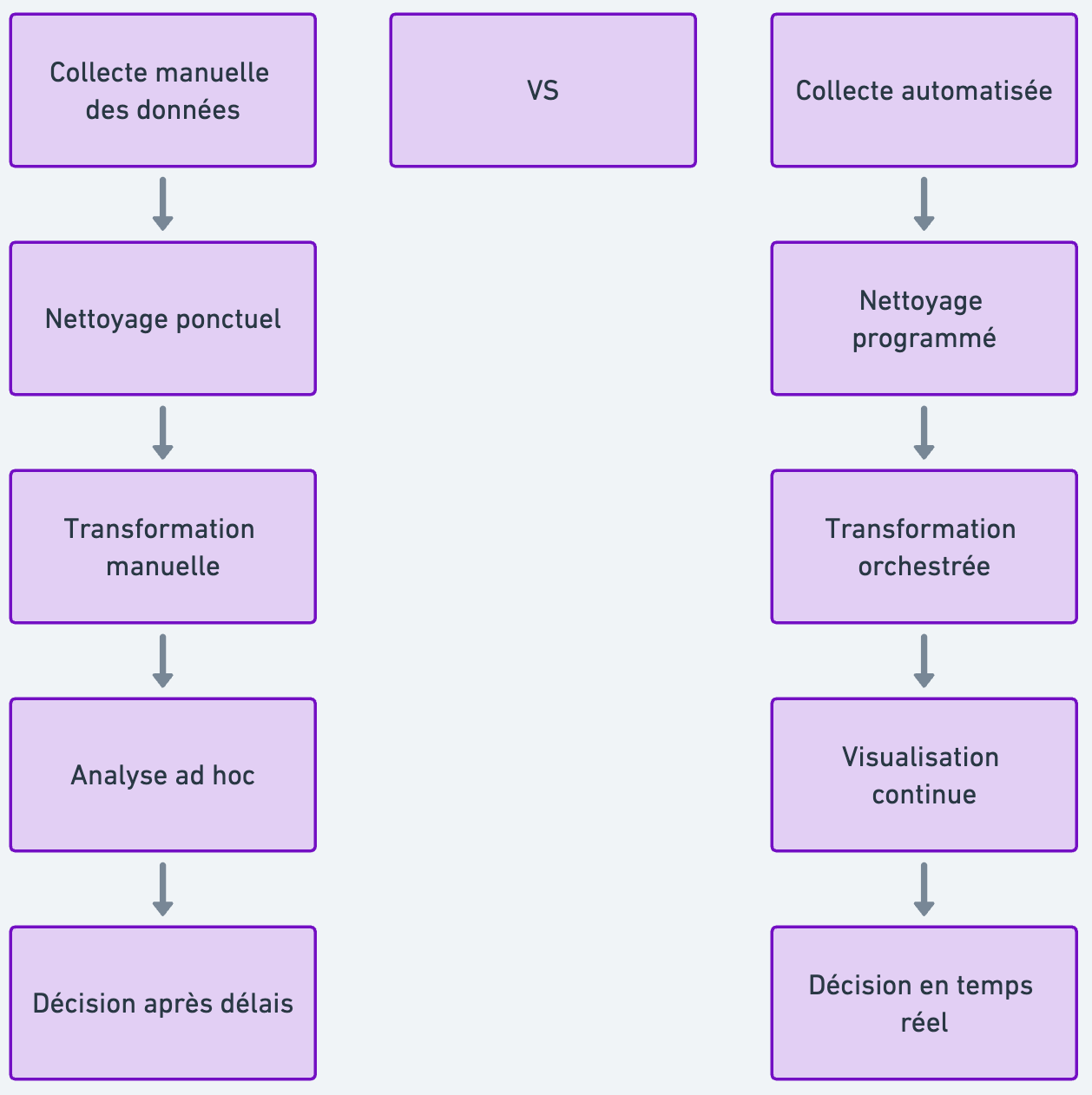

Automatiser les opérations liées à la gestion des données permet d’éliminer une grande partie des erreurs humaines, d’accélérer le traitement de l’information et de libérer du temps pour des activités à plus forte valeur.

Plutôt que de passer des heures à recopier des fichiers ou à répéter des manipulations manuelles, les équipes peuvent se concentrer sur l’analyse, la prise de décision et l’innovation.

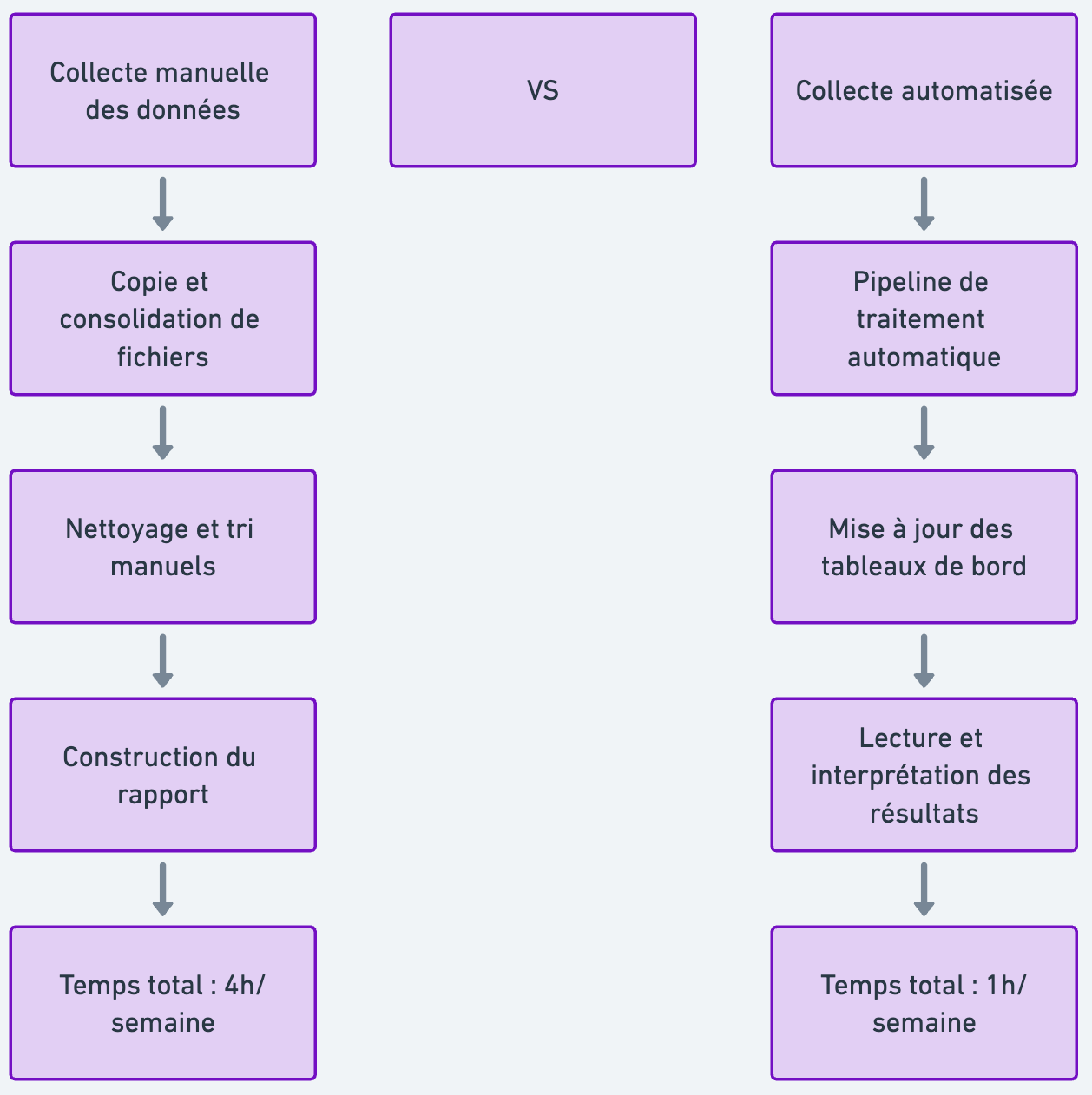

Clara, par exemple, consacrait près de quatre heures chaque semaine à construire son rapport de ventes. Depuis le déploiement de son data workflow, elle ne consacre plus qu’une heure à la lecture et à l’interprétation des tableaux de bord.

Le reste s’exécute automatiquement en arrière-plan.

Fiabiliser les données et assurer leur traçabilité

Un autre atout majeur du data workflow réside dans la traçabilité.

Chaque étape est enregistrée, ce qui permet de savoir exactement quelle source a été utilisée, quels filtres ou transformations ont été appliqués et quel niveau de qualité est garanti dans le résultat final.

Cette fiabilité est indispensable pour toute organisation, particulièrement dans les secteurs fortement régulés. Clara n’a plus à se demander si ses chiffres sont cohérents : elle peut désormais retracer l’intégralité du chemin de ses données, depuis l’extraction initiale jusqu’au tableau de bord final.

Cette transparence renforce la confiance des équipes métiers et évite les doutes lors des prises de décision.

Créer un service data accessible et pérenne

Le data workflow ne doit pas être envisagé comme une simple succession de scripts isolés, mais comme un véritable produit data.

C’est un service à part entière, pensé pour être exploité par différents collaborateurs et accessible en libre-service.

Il offre une structure claire au travail autour de la donnée, uniformise les formats, fluidifie la communication entre les métiers et réduit la dépendance à une seule personne ou à une expertise spécifique.

En rendant les workflows accessibles à tous, l’entreprise s’assure que la donnée devient une ressource commune, pérenne et utile à long terme.

Construire un Data Workflow : méthode étape par étape

Identifier les besoins métiers et les ressources disponibles

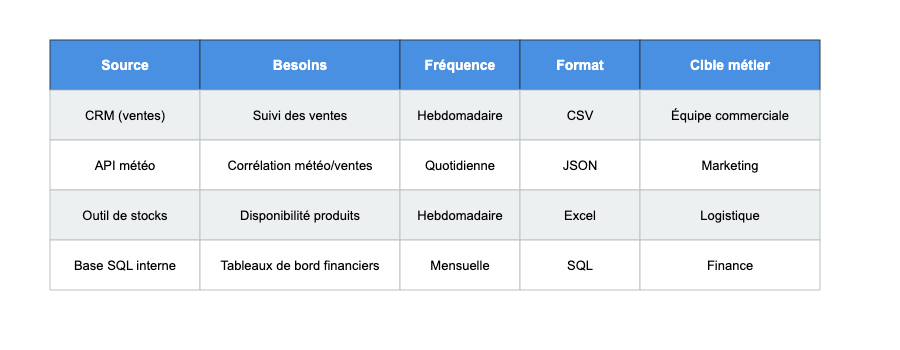

Avant toute mise en place, il faut comprendre :

- Les besoins métiers : rapport hebdo ? alertes ? indicateurs ?

- Les sources : CRM, API, bases de données, fichiers Excel ?

- Les contraintes : fréquence de mise à jour, volume, format

Clara a identifié trois sources de données : ventes CRM, stocks (Excel) et météo (API). Son besoin est un dashboard hebdomadaire mis à jour automatiquement.

Choisir les bons logiciels et plateformes

Le choix des logiciels dépend toujours de la complexité du projet, du volume de données et des compétences disponibles.

Pour un besoin simple, des outils accessibles comme Make, Zapier ou Google Sheets permettent déjà d’automatiser la collecte et de centraliser les informations sans effort technique.

Lorsque les flux deviennent plus lourds ou que la fiabilité est critique, il est préférable d’adopter des solutions plus robustes comme dbt, Airflow, Snowflake ou Looker, qui apportent de la rigueur et une meilleure gouvernance.

Enfin, certains secteurs très sensibles, comme la banque ou l’e-commerce, privilégient des solutions de Business Process Management ou des architectures cloud natives capables de gérer des workflows critiques avec une forte exigence de sécurité.

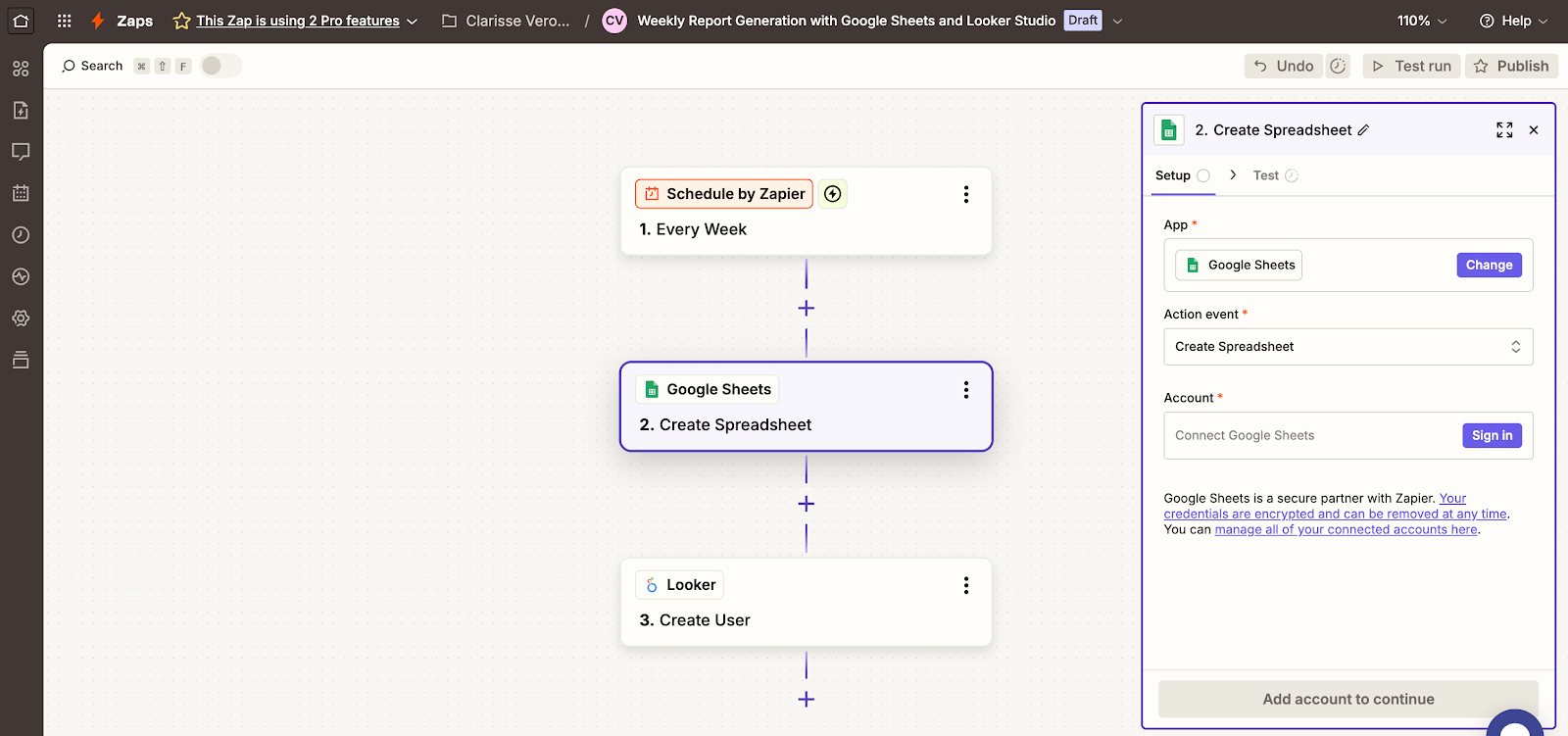

Dans le cas de Clara, inutile d’adopter une usine à gaz. Son objectif était de produire un rapport hebdomadaire fiable sans complexifier son environnement. Elle a donc choisi une pile légère : Zapier pour orchestrer les flux, Google Sheets comme espace tampon et Looker Studio pour générer automatiquement ses tableaux de bord.

Cette combinaison simple lui apporte déjà un gain de temps considérable.

Voici un exemple de flux que Clara aurait pu adopter sur Zapier :

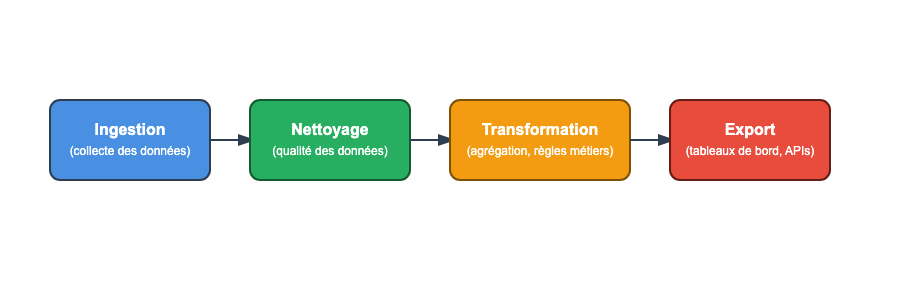

Déployer par briques réutilisables

Un bon data workflow repose sur une logique modulaire. Il ne s’agit pas de construire un pipeline monolithique difficile à maintenir, mais d’assembler des briques indépendantes qui communiquent entre elles.

Chaque étape – l’ingestion, le nettoyage, la transformation puis l’export – doit être conçue comme une pièce détachable. Cette approche permet de tester séparément chaque brique, de corriger rapidement une erreur sans bloquer l’ensemble, et surtout de documenter clairement les ressources utilisées.

En pratique, si Clara veut automatiser son reporting hebdomadaire, elle va commencer par une brique d’ingestion qui se charge de collecter les ventes et les données météo.

Puis elle ajoute une brique de nettoyage qui corrige les valeurs manquantes.

Ensuite, une brique de transformation agrège les ventes par région.

Enfin, une brique d’export envoie le tout vers son tableau de bord.

L’avantage de ce fonctionnement en briques est double : la maintenance est simplifiée et l’équipe peut collaborer plus facilement. On ne construit pas un script fragile, mais bien un produit data durable, aligné sur les besoins métiers et capable d’évoluer au fil des projets.

Capitaliser sur la Culture Data pour pérenniser ses workflows

Transformer la donnée en produit interne

Les workflows deviennent de véritables produits data : avec un objectif, des utilisateurs, un niveau de qualité, un cycle de mise à jour, un propriétaire. Cela permet une meilleure organisation et une vision long terme.

Chez DataBird, nous accompagnons les équipes dans cette transformation, en les aidant à mettre en œuvre des processus pérennes et collaboratifs.

Monter en compétences grâce à la formation

Construire un workflow robuste et durable ne dépend pas uniquement des outils. Cela demande de véritables compétences, à la croisée entre technique et métier.

Les équipes doivent comprendre les processus métiers qu’elles automatisent, savoir orchestrer plusieurs systèmes de données, maîtriser les techniques de nettoyage et de transformation, puis restituer les résultats dans des tableaux de bord adaptés aux utilisateurs. Autrement dit, elles doivent passer du rôle de simples exécutants techniques à celui de véritables ingénieurs de la donnée.

Par exemple, une équipe marketing qui souhaite automatiser son reporting e-commerce doit d’abord connaître ses règles métiers : quels KPI suivre, à quelle granularité, et sur quelle période.

Elle doit ensuite apprendre à manipuler des plateformes d’orchestration, comme Airflow ou Make, pour automatiser l’actualisation de ses données.

Puis vient la phase de nettoyage et de transformation, essentielle pour fiabiliser les résultats. Enfin, la restitution dans des outils de visualisation comme Looker Studio ou Power BI demande une vraie réflexion de conception afin que les tableaux de bord apportent de la valeur aux utilisateurs métiers.

Chez DataBird, notre programme Analytics Engineer permet de former les équipes à la mise en place de workflows robustes, adaptés à leur secteur et à leurs projets.

Votre futur workflow au service de votre activité

Le data workflow n’est pas qu’un outil technique. C’est un levier de productivité, de collaboration et de création de valeur. Il transforme des tâches manuelles en services automatisés, améliore la qualité des données et rend les informations accessibles à tous.

Vous souhaitez vous former et apprendre les workflows Data ? Rejoignez dès maintenant notre formation Analytics Engineer !

Les derniers articles sur ce sujet

.webp)

Lean Management et data : comment gagner en efficacité opérationnelle ?