DeepSeek V2 : nouveau modèle de l’IA et capacités améliorées

Deepseek s’impose comme nouveau géant de l’intelligence artificielle avec son nouveau modèle Deepseek V2 dédié aux développeurs.

Découvrez notre formation en Gen AI et exploitez tout le potentiel de la Gen AI au quotidien.

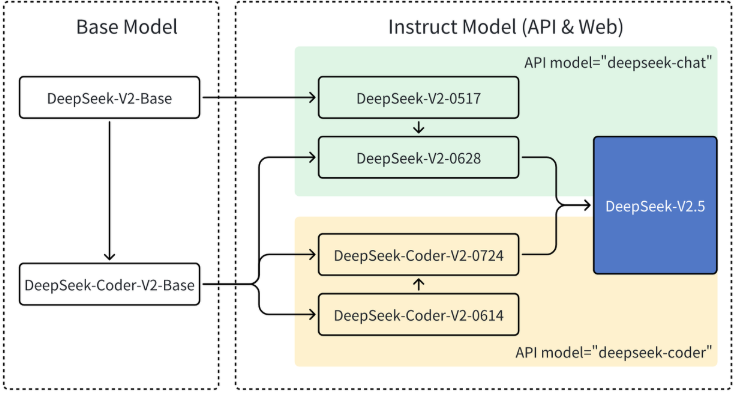

Face aux modèles des géants américains que sont OpenAI et Anthropic avec Claude 3 Opus, la start-up DeepSeek arrive avec DeepSeek V2 : un nouvel arrivé open source qui combine DeepSeek Coder et un modèle de langage naturel aux performances impressionnantes, dépassant les standards établis comme LLaMA 3 70B dans les tâches de codage et de traitement du langage. Les utilisateurs de France et d'ailleurs pourraient bientôt délaisser Codestral pour ce modèle conçu pour accompagner les développeurs dans leur travail quotidien de génie logiciel. Ce modèle basé sur l'architecture MoE en open-source marque des améliorations notables en matière de précision.

DeepSeek V2 : fiche d'identité du modèle de langage naturel et d'aide au codage

DeepSeek-V2 est un deepseek LLM utilisant une architecture Mixture-of-Experts (MoE) comprenant 236 milliards de paramètres, dont 21 milliards de paramètres actifs sont activés pour chaque token lors du traitement. Le modèle emploie une architecture d'attention innovante appelée MLA, conçue pour optimiser l'inférence. Pour les réseaux Feed-Forward, il adopte l'architecture DeepSeekMoE, permettant un pré-entraînement plus performant à coûts réduits.

DeepSeek a été pré-entraîné sur un corpus diversifié comprenant 8,1 trillions de données. Bien que la composition exacte ne soit pas détaillée, les évaluations démontrent de solides capacités en traduction et en langage chinois, sans perte de performances en anglais.

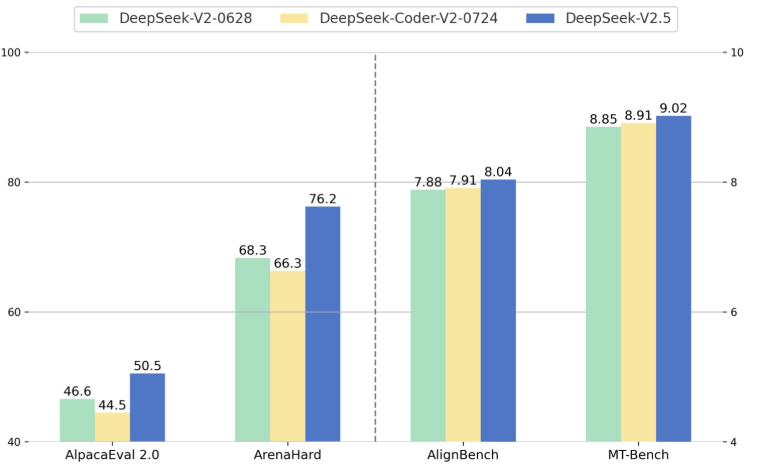

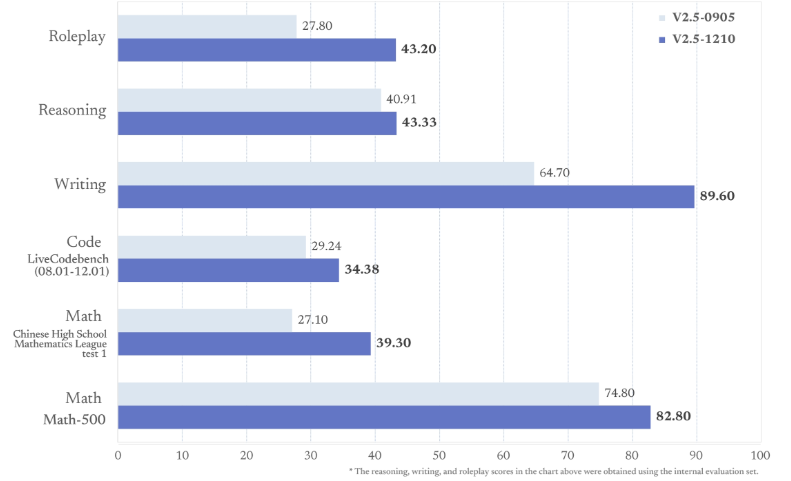

En comparaison avec les modèles concurrents, DeepSeek Coder V2 Base et DeepSeek Coder V2 Instruct surpassent GPT-4 Turbo dans les tâches de codage, une première pour une oeuvre d' intelligence artificielle open source. Il surpasse même le successeur attendu de DeepSeek V3 sur le benchmark LiveCodeBench. Sur Alignbench pour la génération en chinois, DeepSeek-V2 Chat obtient un score comparable à GPT-4.

Face à Mistral Mixtral, DeepSeek-V2 affiche des performances similaires voire supérieures sur des benchmarks en anglais, tout en le surpassant largement en chinois. Comparé à Claude 3 Opus, DeepSeek Coder V2 montre des résultats significativement supérieurs dans le code et les mathématiques.

Deepseek Coder V2 : un vrai concurrent à GPT 4 et Claude 3 opus ?

DeepSeek a de quoi rivaliser avec les meilleurs modèles sur les tests d'évaluation standards, obtenant 78,5% aux questionnaires de connaissances générales, 48,8% en résolution de problèmes de programmation et 79,2% en mathématiques, des performances comparables à LLaMA 3 70B. Sa version après fine-tuning améliore ces résultats avec 81,1% en codage et 92,2% en mathématiques. DeepSeek R1, une dérivation expérimentale du modèle, se distingue particulièrement en chinois, avec des scores de 81,7% et 84,0% aux tests de compréhension, surpassant nettement ses concurrents. La version spécialisée pour les développeurs dépasse même les outils d' intelligence artificielle les plus puissants du marché dans les tâches de programmation, tandis que son apprentissage sur un large éventail de code source lui confère une maîtrise approfondie de nombreux langages.

En termes d'efficacité, DeepSeek-V2 est présenté comme ayant un entraînement économique et une inférence optimisée. Les modèles sont disponibles en open source sous licence MIT, autorisant l'usage commercial sans risque juridique pour les utilisateurs. Une API compatible est également disponible via la plateforme DeepSeek.

Ce que change l'architecture MoE pour les modèles d'aide au code

L'architecture de DeepSeek basée sur le Mixture-of-Experts (mélange d'experts - MoE) représente un changement majeur par rapport aux architectures traditionnelles. Au lieu d'avoir un seul grand réseau neuronal, un modèle MoE est composé de plusieurs "experts" spécialisés, raison pour laquelle son nom inclut cette référence lors de sa création.

Cette architecture permet à DeepSeek-V2 d'avoir une capacité accrue avec un coût de calcul gérable. Malgré ses 236 milliards de paramètres, seuls 21 milliards sont activés pour chaque traitement, rendant le coût de calcul significativement inférieur à ce que suggère le nombre total de paramètres.

Les performances sont améliorées grâce à la spécialisation des différentes parties du réseau pour traiter divers types d'entrées ou de tâches. L'entraînement devient plus économique, avec 42,5% d'économies par rapport à DeepSeek 67B.

L'inférence gagne en efficacité grâce à l'architecture MoE combinée à l'utilisation de MLA, éliminant les goulets d'étranglement. Cela se traduit par une réduction du cache de 93,3% et une augmentation du débit de génération maximal de 5,76 fois.

Applications concrètes de Deepseek V2 pour les entreprises

DeepSeek Coder V2 transforme le quotidien des développeurs en matière de génie logiciel à travers plusieurs capacités avancées. Le modèle excelle dans la génération automatique de code à partir de descriptions textuelles, tout en offrant une complétion intelligente en temps réel. Sa capacité à détecter et corriger les erreurs de codage se démarque particulièrement sur les benchmarks comme Defects4J, où il surpasse ses concurrents. Les professionnels bénéficient également de ses aptitudes à optimiser les performances du code existant et à expliciter des concepts techniques complexes.

La résolution de problèmes de programmation constitue un autre point fort du système de DeepSeek, qui peut suivre des instructions précises tout en maintenant une cohérence globale dans le code généré. La documentation automatique, associée à des fonctionnalités de recherche, complète cette offre technique remarquable.

Pour les entreprises de France et d'ailleurs, DeepSeek-V2 ouvre de nouvelles perspectives stratégiques. Le développement d'assistants de codage IA personnalisés devient accessible, améliorant considérablement la productivité des équipes. Les organisations peuvent accélérer la formation des professionnels débutants grâce à cet agent pédagogique performant. Ses capacités de traduction et de traitement multilingue permettent d'envisager des applications internationales diversifiées.

Le traitement de longs contextes représente un atout majeur pour l'analyse de bases de code volumineuses. L'intégration simplifiée de DeepSeek Coder V2 via une API facilite son déploiement dans les infrastructures existantes. L'architecture MoE garantit par ailleurs une inférence efficace et économique, optimisant le rapport coût-performance pour les utilisations intensives de données.

La compatibilité avec des environnements de développement populaires facilite considérablement l'adoption de DeepSeek dans les flux de travail existants, minimisant ainsi les frictions lors de son implémentation.

DeepSeek Coder V2, le vrai tournant de l'intelligence artificielle ?

DeepSeek constitue une avancée majeure pour les IA destinées aux développeurs. En surpassant LLaMA 3 70B et Claude 3 Opus sur des benchmarks clés comme LiveCodeBench, DeepSeek Coder V2 marque une première pour l'intelligence artificielle en modèle open source dans ce domaine.

Ses capacités de génération automatique de code, de complétion intelligente, de détection et correction d'erreurs, ainsi que d'optimisation offrent un potentiel considérable pour transformer le quotidien du génie logiciel. Les utilisateurs en France commencent déjà à explorer cette nouvelle oeuvre de l'IA.

L'intégration facile de DeepSeek Coder V2 dans des environnements de développement populaires facilite son adoption. Sa capacité à comprendre le contexte du code, à suivre des instructions précises et à maintenir la cohérence en fait un allié précieux pour tous les niveaux de professionnels.

L'architecture MoE du modèle DeepSeek-V2 sous-jacent permet d'allier performance et efficacité, tout en offrant une longueur de contexte étendue. La disponibilité d'une API compatible simplifie l'intégration dans des outils existants.

Malgré ses limites, notamment en matière de dépendance à la précision des instructions, DeepSeek se positionne comme un auxiliaire fondamental qui vient compléter l'expertise humaine. En offrant des suggestions pertinentes et des capacités avancées pour toutes sortes de tâches, DeepSeek représente un véritable tournant, propulsant l'assistance par l'IA vers de nouveaux sommets pour la communauté des développeurs.

{{formation-gen-ai="/brouillon"}}

Les derniers articles sur ce sujet

Former les managers à l’IA : une transformation de la productivité

.webp)