Comment intégrer DBT dans sa stack d'outils ?

Découvrez les étapes essentielles pour intégrer efficacement DBT (Data Build Tool) dans votre stack technologique et optimiser vos processus de transformation de données.

Découvrez notre formation Analytics Engineer et développez une des compétences les plus recherchées sur le marché.

L’intégration de DBT (Data Build Tool) est devenue une étape essentielle pour optimiser la transformation des données dans les environnements analytiques modernes.

Conçu pour fonctionner avec un Data Warehouse, cet outil open source permet d’écrire, tester et documenter des modèles SQL afin de garantir la qualité des données et d’améliorer la collaboration au sein des équipes de développement.

Dans cet article, nous allons voir comment mettre en place DBT et se former à DBT, qu’il s’agisse de DBT Core ou DBT Cloud, en détaillant chaque étape clé du processus d’intégration et en expliquant comment automatiser les pipelines de données pour une meilleure gestion des transformations.

Qu'est-ce que DBT (Data Build Tool) ?

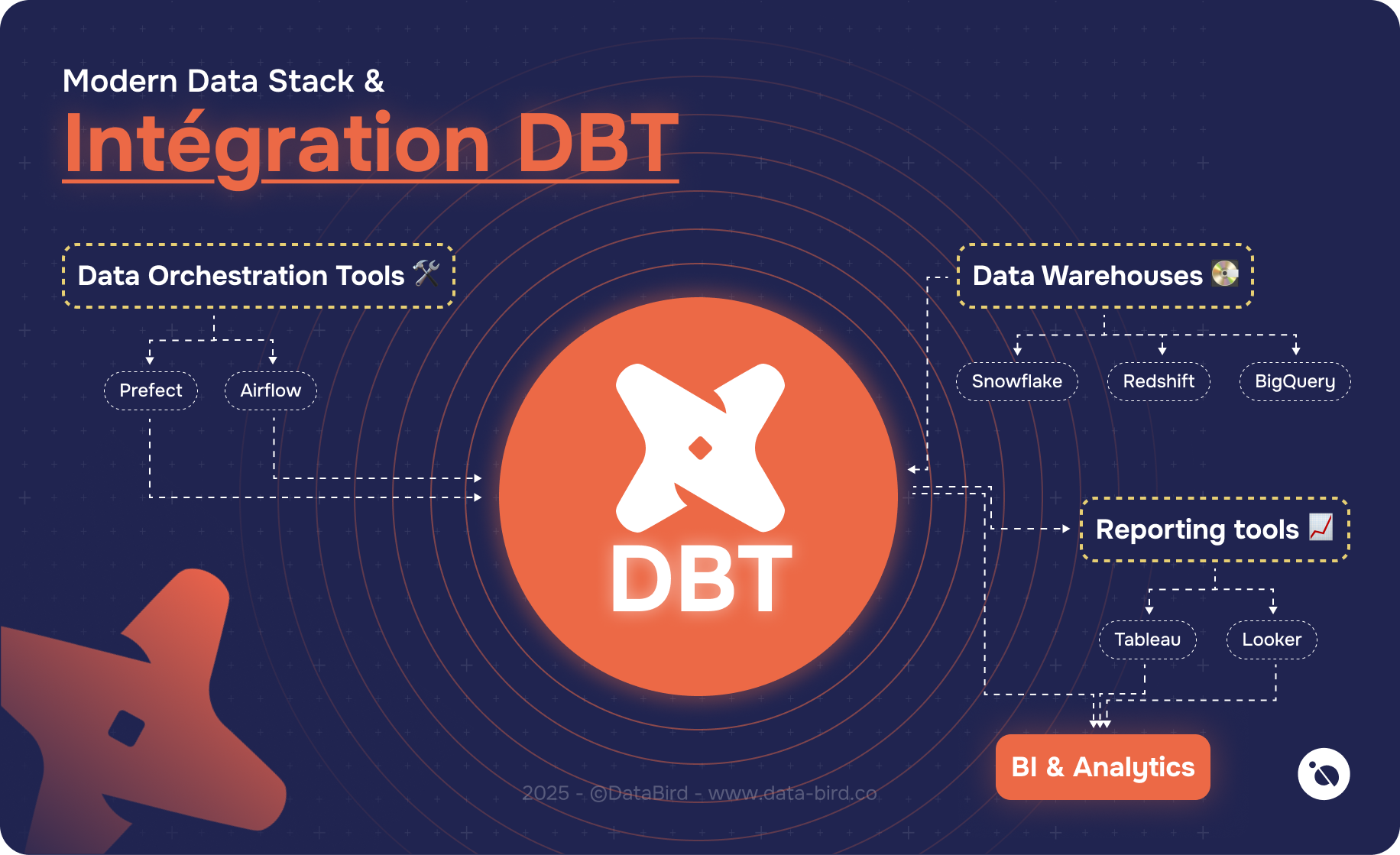

DBT est un outil open source qui facilite la transformation des données directement dans un entrepôt de données comme Snowflake, Redshift ou BigQuery. Contrairement aux solutions ETL (Extract, Transform, Load) qui effectuent la transformation avant le chargement, DBT adopte une approche ELT (Extract, Load, Transform). Les données sont d’abord chargées brutes dans le Data Warehouse, puis transformées via des modèles SQL exécutés directement sur la base de données.

Ce modèle permet de profiter de la puissance de calcul des entrepôts de données modernes tout en assurant une meilleure gestion des transformations grâce à une structure modulaire et à l’automatisation des tests.

DBT est donc un outil clé pour les équipes travaillant sur la Business Intelligence et l’analyse avancée.

DBT est également conçu pour favoriser la collaboration. Grâce à son intégration avec Git, il permet le versioning des modèles SQL, garantissant ainsi une meilleure traçabilité des modifications et une plus grande reproductibilité des résultats.

Pourquoi intégrer DBT dans votre stack technologique ?

L’intégration de DBT dans une infrastructure Data apporte plusieurs avantages.

En premier lieu, DBT améliore la qualité des données en automatisant la validation via des tests intégrés.

Il permet aussi une structuration claire des modèles et des transformations, facilitant ainsi la gestion des workflows et des pipelines de données.

Un autre atout majeur est la simplicité d’utilisation : DBT permet aux analystes et aux ingénieurs data d’écrire leurs transformations en SQL, sans avoir besoin de recourir à des langages plus complexes comme Python. Cette accessibilité permet une adoption rapide et une meilleure collaboration entre les équipes techniques et métiers.

Enfin, DBT s’intègre parfaitement avec d’autres outils du domaine de la Business Intelligence, notamment les plateformes de reporting et d’orchestration comme Airflow ou Databricks.

Étapes pour intégrer DBT dans votre environnement

1. Évaluation de votre infrastructure actuelle

Avant de procéder à l’intégration de DBT, il est essentiel d’analyser votre environnement data pour s’assurer qu’il est compatible avec l’approche ELT et qu’il peut tirer pleinement parti des capacités de DBT.

Cette évaluation passe par trois aspects clés : l’identification du Data Warehouse, l’analyse du processus de chargement des données et la définition des besoins de l’entreprise.

DBT est conçu pour fonctionner avec des Data Warehouses modernes comme BigQuery, Snowflake ou Redshift. Ces plateformes offrent des capacités de stockage et de calcul optimisées pour exécuter des requêtes SQL volumineuses de manière efficace.

Si votre entreprise utilise déjà l’un de ces entrepôts, l’adoption de DBT sera relativement simple. En revanche, si vos données sont stockées dans une base de données transactionnelle classique (comme PostgreSQL ou MySQL), il sera peut-être nécessaire de les migrer vers un entrepôt de données plus adapté aux analyses massives.

DBT applique ses transformations directement sur les données stockées dans le Data Warehouse. Pour que cela fonctionne correctement, il est impératif que les données sources soient chargées telles quelles, sans transformation préalable.

Dans un processus traditionnel ETL (Extract, Transform, Load), les données sont extraites, transformées puis chargées dans l’entrepôt. Cette approche peut poser problème avec DBT, car les transformations ont déjà été effectuées avant le chargement.

En revanche, l’approche ELT (Extract, Load, Transform) est idéale : les données sont d’abord extraites de leurs sources (CRM, ERP, API, bases externes, etc.), puis chargées telles quelles dans l’entrepôt de données. DBT intervient ensuite pour exécuter les transformations, garantissant ainsi une flexibilité et une scalabilité optimales.

Si votre entreprise utilise encore un processus ETL, il faudra probablement revoir le pipeline de données pour migrer vers une approche ELT, en utilisant des connecteurs comme Fivetran, Airbyte ou Stitch pour automatiser le chargement des données sources.

Chaque entreprise a des besoins spécifiques en matière de transformation de données et d’analyse. Avant d’implémenter DBT, il est important de définir ces besoins en posant des questions comme :

- Quels sont les modèles de données utilisés et comment sont-ils actuellement gérés ?

- Quels types de tests de qualité des données doivent être mis en place pour garantir leur fiabilité ?

- Faut-il automatiser certaines tâches comme l’orchestration des pipelines avec Airflow ?

- L’équipe en charge des données a-t-elle les compétences nécessaires pour utiliser SQL et gérer le développement des modèles avec DBT ?

2. Choisir entre DBT Core et DBT Cloud

DBT est disponible sous deux versions.

DBT Core est la version open source, qui s’exécute en ligne de commande sur un environnement local ou un serveur. Elle offre une grande flexibilité, notamment en permettant un contrôle total sur l’exécution des transformations, la gestion des versions et l’intégration avec d’autres outils comme Git ou Airflow.

Cependant, cette liberté implique une plus grande responsabilité : il faut gérer soi-même l’orchestration des pipelines de données, l’exécution des tâches et la maintenance de l’environnement technique. Cette option est particulièrement adaptée aux entreprises disposant déjà d’une équipe technique capable de gérer ces aspects en interne.

DBT Cloud, quant à lui, est une version hébergée qui simplifie l’utilisation de DBT en proposant une interface web intuitive. Il permet de gérer les exécutions sans avoir à se soucier de l’infrastructure sous-jacente. En plus d’intégrer des fonctionnalités avancées comme la planification automatisée des tâches, la gestion des permissions utilisateurs et une exécution optimisée sur le cloud, cette version facilite la collaboration entre les analystes et les ingénieurs data.

Son principal avantage réside dans la réduction du temps de configuration et d’administration, ce qui en fait une solution idéale pour les entreprises cherchant à adopter DBT rapidement sans se soucier des contraintes techniques.

Le choix dépendra des besoins de votre entreprise et de votre capacité à gérer l’infrastructure associée.

3. Tutoriel d'installation et de configuration de DBT

1. Pour installer DBT Core, utilisez la commande suivante :

pip install dbt-core

pip install dbt-redshift # Adaptateur spécifique à votre Data Warehouse2. Vous pouvez créer un nouveau projet dbt grâce à cette commande :

dbt init mon_projet_dbt

3. Puis accédez au dossier et ouvrez-le dans votre éditeur de code par défaut, moi j'utilise VS Code :

cd mon_projet_dbt

La configuration de la connexion au Data Warehouse se fait via le fichier profiles.yml, où sont définis les fichiers de connexion et les sources de données.

4. Définition des modèles SQL et organisation des fichiers

Dans DBT, les transformations sont définies sous forme de modèles SQL, stockés dans des fichiers .sql.

Ceux-ci sont organisés en dossiers (staging, intermediate, marts) pour une meilleure lisibilité et une plus grande reproductibilité des transformations.

Par exemple, un modèle SQL simple permettant de calculer le nombre total de commandes par utilisateur pourrait être défini ainsi :

SELECT user_id, COUNT(order_id) AS total_orders FROM {{ source('ecommerce', 'orders') }} GROUP BY user_id

5. Automatisation des tests pour assurer la qualité des données

DBT permet d’intégrer des tests directement dans les modèles SQL pour valider la qualité des données. Par exemple, on peut s’assurer qu’un user_id est toujours unique et non nul :

version: 2 models: - name: users columns: - name: user_id tests: - unique - not_null

L’exécution de ces tests garantit que les données sont toujours conformes avant leur exploitation.

6. Orchestration des pipelines de données avec DBT et Airflow

Pour automatiser l’exécution des pipelines de données, DBT peut être intégré à un orchestrateur comme Airflow. En définissant des workflows, il est possible d’automatiser l’exécution des transformations selon un calendrier défini.

Dans Airflow, une tâche DBT pourrait être configurée ainsi :

from airflow.providers.dbt.cloud.operators.dbt import DbtRunOperator

dbt_run = DbtRunOperator(

task_id='dbt_run',

dbt_cloud_conn_id='dbt_cloud_default',

job_id=12345

)

L’utilisation de cet orchestrateur permet de fiabiliser l’ensemble du processus et d’assurer une mise en place robuste et scalable des transformations.

Meilleures pratiques pour une intégration réussie

Une bonne gestion des transformations passe par une organisation rigoureuse des modèles SQL et des fichiers de projet.

Il est recommandé de structurer les transformations en trois couches :

- staging (préparation des données brutes)

- intermediate (transformation intermédiaire)

- marts (modèles finaux destinés à l’analyse).

L’automatisation des tests et la documentation des modèles avec dbt docs generate améliorent la qualité et la compréhension des transformations.

Enfin, la mise en place d’un pipeline CI/CD avec Git permet d’assurer la reproductibilité et la fiabilité des modifications.

L’intégration de DBT est une étape clé pour moderniser une infrastructure data et améliorer la gestion des pipelines de données.

En suivant ces bonnes pratiques, vous garantissez une adoption réussie et une meilleure exploitation des données pour votre entreprise.

À qui faire appel pour aider mon entreprise à intégrer DBT ?

L’intégration de DBT dans une infrastructure de données peut être un défi, surtout si votre entreprise ne possède pas encore d’expérience avec les outils de transformation de données et l’approche ELT. Pour garantir une mise en place efficace et tirer pleinement parti de DBT, plusieurs options s’offrent à vous.

Faire appel à une équipe interne peut être une solution si votre entreprise dispose déjà de Data Engineers et d’analystes maîtrisant SQL et les architectures Data Warehouse. Dans ce cas, une formation sur DBT peut suffire pour que votre équipe devienne autonome.

Si vous avez besoin d’une expertise externe, des consultants spécialisés en Modern Data Stack peuvent vous accompagner dans la configuration de DBT, l’optimisation de vos modèles SQL et l’automatisation des pipelines de données. Ces experts peuvent aussi vous aider à intégrer DBT avec d’autres outils comme Airflow, Prefect ou des solutions cloud comme Snowflake et BigQuery.

Les entreprises qui souhaitent accélérer leur adoption de DBT peuvent également se tourner vers des partenaires spécialisés, qui proposent des formations sur mesure et un accompagnement complet pour adapter DBT aux besoins spécifiques de leur domaine d’activité.

Si vous cherchez une formation ou un accompagnement pour l'intégration de DBT, nous pouvons vous aider !

{{cours-gratuit-dbt="/brouillon"}}

Les derniers articles sur ce sujet

Data Workflow : Optimisez vos Flux de Données, Boostez votre Productivité